ICSEJOURNALICSEJOURNAL

Journal of Computer Science and Engineering (JCSE)Journal of Computer Science and Engineering (JCSE)Pengembangan pemrosesan bahasa alami (NLP) berbasis transformer telah membawa kemajuan signifikan pada sistem penjawab pertanyaan (QA). Penelitian ini membandingkan tiga model utama, yaitu BERT, Sequence-to-Sequence (S2S), dan Generative Pretrained Transformer (GPT), dalam memahami dan menjawab pertanyaan berbasis konteks menggunakan dataset SQuAD 2.0 yang telah diterjemahkan ke dalam bahasa Indonesia. Penelitian ini menggunakan metode SEMMA (Sample, Explore, Modify, Model, Assess) untuk memastikan proses analisis berjalan secara sistematis dan efisien. Model diuji dengan metrik evaluasi exact match (EM), F1-score, dan ROUGE. Hasil menunjukkan bahwa BERT unggul dengan skor Exact Match 99,57 %, F1-score 99,57 %, ROUGE-1 97 %, ROUGE-2 30 %, dan ROUGE-L 97 %, melebihi kinerja model S2S dan GPT. Studi ini membuktikan bahwa BERT lebih efektif dalam memahami dan menangkap konteks bahasa Indonesia pada tugas QA. Penelitian ini memberikan penjelasan mengenai implementasi QA berbasis bahasa Indonesia dan dapat menjadi referensi dalam pengembangan sistem NLP yang lebih akurat dan efisien.

Berdasarkan hasil penelitian, model BERT memperoleh hasil terbaik dalam tugas penjawaban pertanyaan faktual menggunakan dataset SQuAD v2.0 berbahasa Indonesia, dengan nilai Exact Match dan F1‑score masing‑masing sebesar 99,57 % serta nilai ROUGE‑1 dan ROUGE‑L sebesar 97 %.Keunggulan BERT disebabkan oleh arsitektur perhatian dua arah yang lebih efektif dalam menangkap hubungan antar kata dibandingkan model S2S dan GPT.Model S2S menunjukkan kinerja lebih rendah pada pemahaman konteks, sementara GPT meskipun menghasilkan teks yang natural, kurang akurat dalam menjawab pertanyaan faktual.

Penelitian selanjutnya dapat menyelidiki bagaimana transfer lintas bahasa dapat meningkatkan kemampuan sistem QA berbahasa Indonesia dengan memanfaatkan model multibahasa besar dan korpus paralel untuk mengurangi kebutuhan data berlabel. Selain itu, studi dapat mengevaluasi teknik fine‑tuning parameter‑efisien yang lebih maju daripada LoRA, seperti AdapterFusion atau Prompt‑Tuning, untuk menurunkan konsumsi memori dan waktu pelatihan pada model BERT dan GPT tanpa mengorbankan akurasi pada dataset SQuAD‑Indonesia. Penelitian ketiga dapat mengembangkan model hibrida yang menggabungkan representasi bidirectional BERT dengan kemampuan generatif GPT, untuk meningkatkan keakuratan jawaban faktual sekaligus menghasilkan output yang lebih natural pada pertanyaan berlapis atau ambigu. Setiap pendekatan tersebut harus diuji secara komprehensif menggunakan metrik EM, F1, dan ROUGE serta analisis error mendalam, sehingga dapat memberikan panduan praktis bagi pengembangan sistem QA berbahasa Indonesia yang lebih efektif dan efisien. Dengan demikian, eksplorasi tersebut tidak hanya akan memperluas pemahaman ilmiah tentang adaptasi model bahasa besar pada bahasa Indonesia, tetapi juga berpotensi mempercepat penerapan QA cerdas dalam layanan publik, pendidikan, dan sektor bisnis.

- Complex Knowledge Base Question Answering: A Survey | IEEE Journals & Magazine | IEEE Xplore. complex... ieeexplore.ieee.org/document/9960856Complex Knowledge Base Question Answering A Survey IEEE Journals Magazine IEEE Xplore complex ieeexplore ieee document 9960856

- Transfer Learning in Natural Language Processing - ACL Anthology. transfer learning natural language... aclanthology.org/N19-5004Transfer Learning in Natural Language Processing ACL Anthology transfer learning natural language aclanthology N19 5004

- IndoLEM and IndoBERT: A Benchmark Dataset and Pre-trained Language Model for Indonesian NLP - ACL Anthology.... aclanthology.org/2020.coling-main.66IndoLEM and IndoBERT A Benchmark Dataset and Pre trained Language Model for Indonesian NLP ACL Anthology aclanthology 2020 coling main 66

| File size | 507.68 KB |

| Pages | 10 |

| DMCA | Report |

Related /

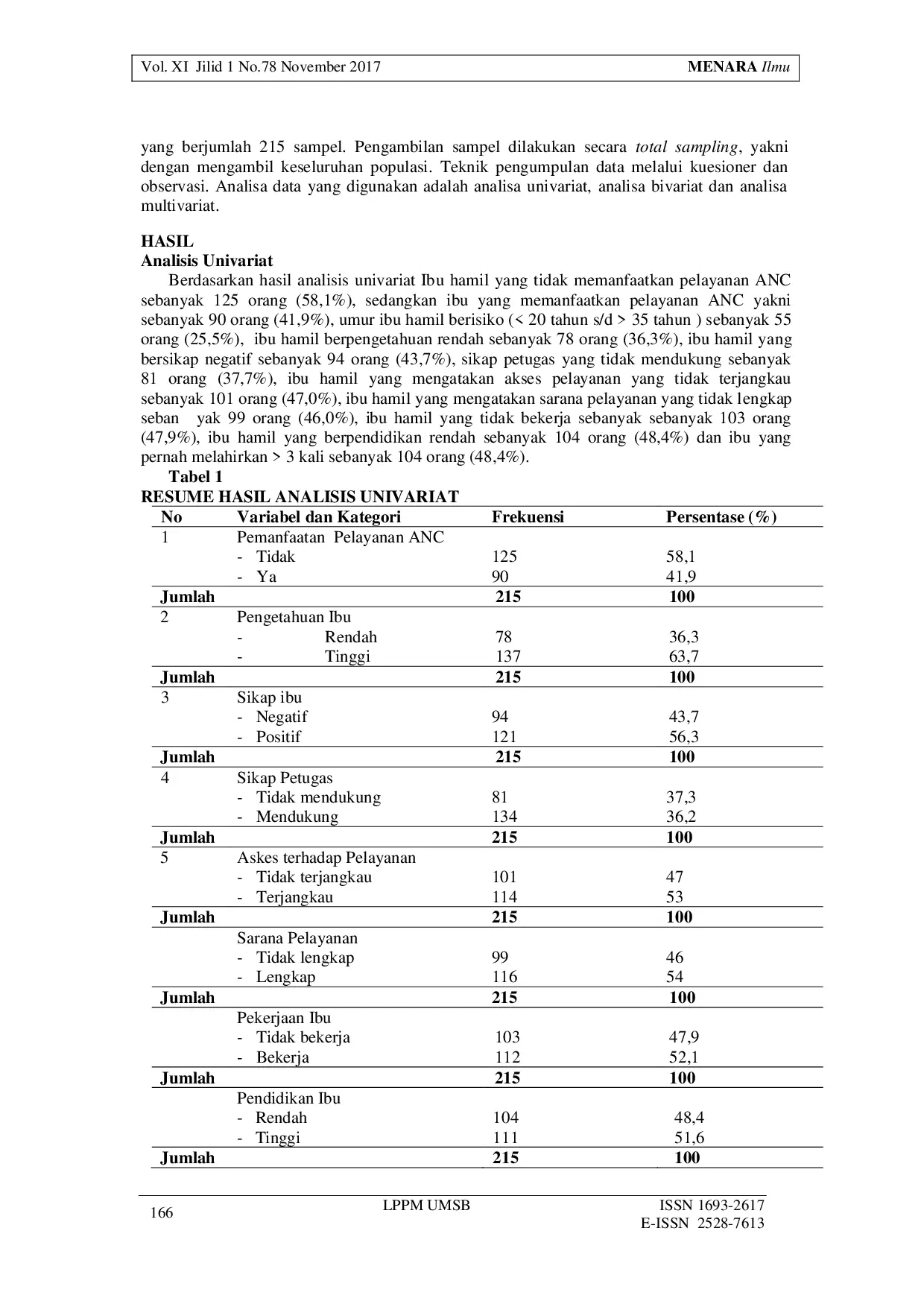

UMSBUMSB Penelitian ini menggunakan desain cross sectional dengan sampel 36 bidan. Hasil penelitian menunjukkan adanya hubungan bermakna antara pengetahuan bidanPenelitian ini menggunakan desain cross sectional dengan sampel 36 bidan. Hasil penelitian menunjukkan adanya hubungan bermakna antara pengetahuan bidan

DIGLOSIA UNMULDIGLOSIA UNMUL Cerita rakyat tentang sumber air di Klaten belum terakses luas sehingga nilai keberlanjutan sumber air dan kelestarian lingkungan tidak tersampaikan. TujuanCerita rakyat tentang sumber air di Klaten belum terakses luas sehingga nilai keberlanjutan sumber air dan kelestarian lingkungan tidak tersampaikan. Tujuan

JOURNALCENTERJOURNALCENTER Penetrasi teknologi business intelligence mencapai 31,18% untuk dashboard dan 10,75% untuk teknik clustering dalam ekosistem usaha kecil menengah, menandaiPenetrasi teknologi business intelligence mencapai 31,18% untuk dashboard dan 10,75% untuk teknik clustering dalam ekosistem usaha kecil menengah, menandai

SUBSETSUBSET Penelitian mengikuti pendekatan CRISP-DM dan menerapkan teknik SMOTE untuk mengatasi ketidakseimbangan kelas serta Grid Search CV untuk optimasi hyperparameter.Penelitian mengikuti pendekatan CRISP-DM dan menerapkan teknik SMOTE untuk mengatasi ketidakseimbangan kelas serta Grid Search CV untuk optimasi hyperparameter.

ICSEJOURNALICSEJOURNAL Metrik evaluasi, termasuk akurasi, presisi, recall, dan F1-score, digunakan untuk mengevaluasi kinerja model yang telah dilatih. Hasil menunjukkan bahwaMetrik evaluasi, termasuk akurasi, presisi, recall, dan F1-score, digunakan untuk mengevaluasi kinerja model yang telah dilatih. Hasil menunjukkan bahwa

UNMUNM Kesenjangan gender dalam literasi dan numerasi tetap menjadi tantangan utama bagi pendidikan yang adil, terutama di komunitas linguistik beragam dan pribumi.Kesenjangan gender dalam literasi dan numerasi tetap menjadi tantangan utama bagi pendidikan yang adil, terutama di komunitas linguistik beragam dan pribumi.

STIBAIEC JAKARTASTIBAIEC JAKARTA Untuk mencapai tujuan tersebut, fokus tidak hanya pada aspek linguistik, melainkan juga pada unsur sastra dan budaya. Karena dongeng menyediakan unsur‑unsurUntuk mencapai tujuan tersebut, fokus tidak hanya pada aspek linguistik, melainkan juga pada unsur sastra dan budaya. Karena dongeng menyediakan unsur‑unsur

UMSBUMSB Penelitian selanjutnya perlu dilakukan dengan memperbesar sampel dan menggunakan metode wawancara untuk mendapatkan data yang lebih mendalam. Selain itu,Penelitian selanjutnya perlu dilakukan dengan memperbesar sampel dan menggunakan metode wawancara untuk mendapatkan data yang lebih mendalam. Selain itu,

Useful /

IJAR IAIKAPDIJAR IAIKAPD Berdasarkan hasil analisis hipotesis dan pengujian dalam paper ini, dapat disimpulkan bahwa rata-rata beban pajak penghasilan koperasi yang menjadi respondenBerdasarkan hasil analisis hipotesis dan pengujian dalam paper ini, dapat disimpulkan bahwa rata-rata beban pajak penghasilan koperasi yang menjadi responden

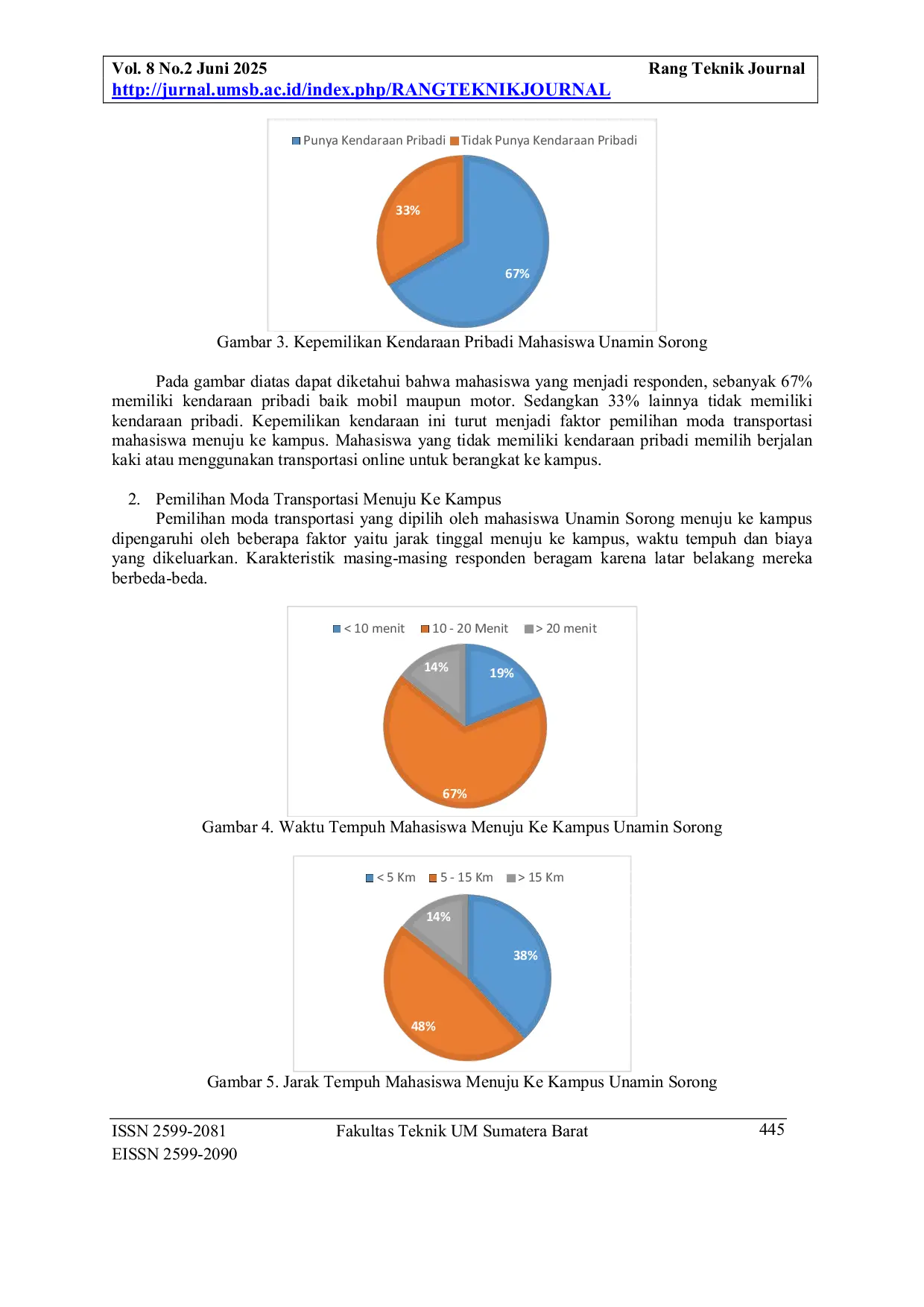

UMSBUMSB Keberadaan kampus ini menjadi faktor penarik mahasiswa yang berasal dari berbagai daerah untuk datang memenuhi kebutuhan pendidikan. Pergerakan menujuKeberadaan kampus ini menjadi faktor penarik mahasiswa yang berasal dari berbagai daerah untuk datang memenuhi kebutuhan pendidikan. Pergerakan menuju

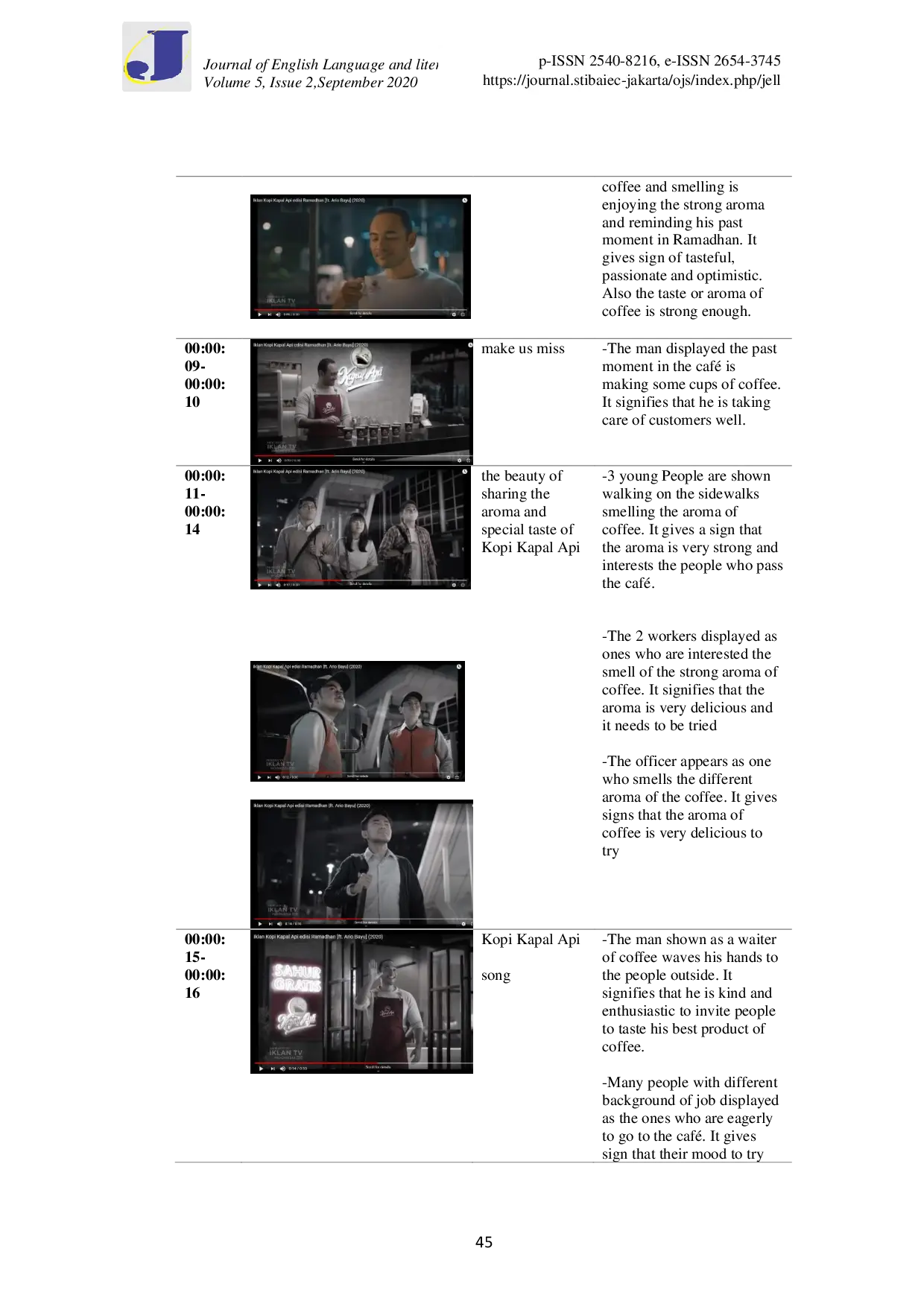

STIBAIEC JAKARTASTIBAIEC JAKARTA Metode penelitian kualitatif dengan pendekatan analisis konten digunakan karena studi ini membutuhkan analisis mendalam terhadap konten, yaitu tanda-tandaMetode penelitian kualitatif dengan pendekatan analisis konten digunakan karena studi ini membutuhkan analisis mendalam terhadap konten, yaitu tanda-tanda

STIBAIEC JAKARTASTIBAIEC JAKARTA Selama pandemi COVID-19, banyak kata dan frasa asing diserap ke dalam bahasa Indonesia melalui proses adopsi, adaptasi, dan terjemahan. Proses adaptasiSelama pandemi COVID-19, banyak kata dan frasa asing diserap ke dalam bahasa Indonesia melalui proses adopsi, adaptasi, dan terjemahan. Proses adaptasi